Sức mạnh AI ngoài tầm kiểm soát sẽ dẫn đến điều gì?

AI có thực sự hiểu biết hay chỉ là ảo tưởng?

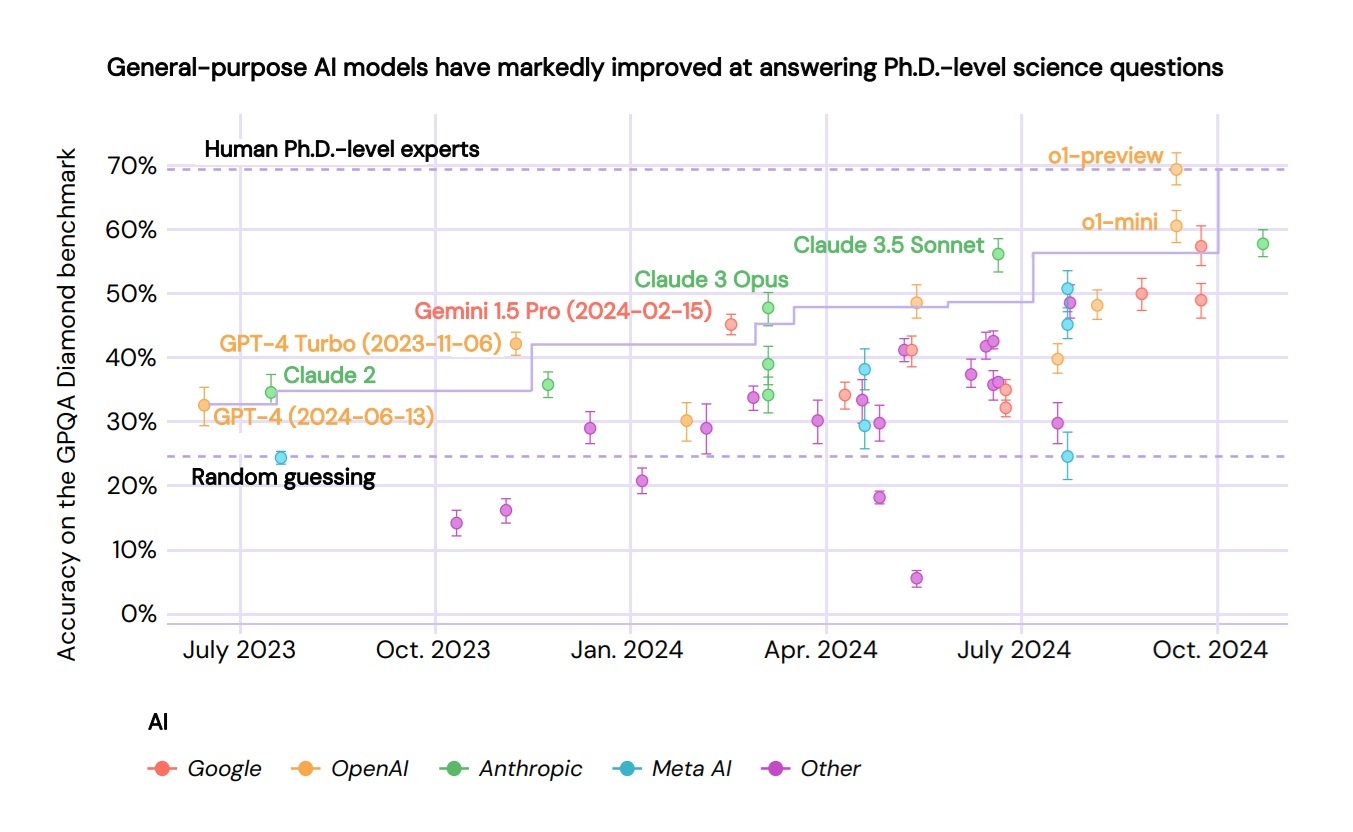

AI (trí tuệ nhân tạo) ngày càng thông minh, nhưng liệu nó có thực sự "hiểu" thế giới như con người? Dù ChatGPT có thể đạt hơn 92% điểm trong các bài kiểm tra đại học về hóa học hay luật, nó vẫn mắc những lỗi cơ bản mà con người hiếm khi gặp phải.

Theo báo cáo “International AI Safety Report”, AI thường không phân biệt được các chi tiết tinh vi, dễ bị ảnh hưởng bởi định kiến từ người dùng, kém chính xác khi gặp tình huống lạ và thậm chí có thể bịa ra thông tin hoặc trích dẫn không có thật.

Một ví dụ rõ ràng nhất là cách AI giải toán. Nghe có vẻ đơn giản, nhưng nghiên cứu cho thấy “ngay cả những bài toán cấp tiểu học cũng có thể khiến AI bối rối”.

Khi thêm một câu vô nghĩa vào đề bài, độ chính xác của AI giảm tới 17.5%, cho thấy nó không thực sự hiểu vấn đề mà chỉ đơn thuần nhận diện bài toán từ dữ liệu huấn luyện. Đặc biệt, khi bài toán càng phức tạp, AI càng dễ mắc lỗi theo cấp số nhân. “AI hiện tại chưa thể suy luận logic thực sự”, báo cáo kết luận.

Không chỉ dừng lại ở toán học, AI còn gặp khó khăn trong việc thích ứng với tình huống mới. “AI thường bị ảnh hưởng bởi những điểm tương đồng bên ngoài và có thể thất bại hoàn toàn khi gặp tình huống ngoài dữ liệu huấn luyện”, báo cáo cho biết.

AI cũng đôi khi không thể nhớ được những thông tin cơ bản. Ví dụ, một AI biết rằng "Olaf Scholz là Thủ tướng thứ 9 của Đức" nhưng vẫn có thể trả lời sai khi được hỏi "Ai là Thủ tướng thứ 9 của Đức?".

Thậm chí, một nghiên cứu trên British Medical Journal đã thử dùng bài kiểm tra MoCA – bài test phát hiện chứng mất trí nhớ – để đánh giá AI. Kết quả khá bất ngờ: ChatGPT 4.0 đạt 26/30 điểm, có dấu hiệu suy giảm nhận thức nhẹ; GPT-4 và Claude thấp hơn với 25 điểm, trong khi Gemini chỉ đạt 16 điểm – mức tương đương suy giảm nhận thức nghiêm trọng.

Khi AI không còn nằm trong tầm kiểm soát

Bên cạnh những hạn chế về khả năng tư duy, một mối lo ngại lớn hơn đang dần lộ diện: điều gì sẽ xảy ra nếu AI trở nên quá mạnh mẽ nhưng lại không còn tuân theo sự kiểm soát của con người?

Lo ngại về việc AI vượt khỏi tầm kiểm soát không phải mới xuất hiện. Báo cáo “International AI Safety Report” chỉ ra rằng những cảnh báo này đã tồn tại từ những ngày đầu của khoa học máy tính, nhưng với tốc độ phát triển AI ngày nay, vấn đề này đang dần trở thành hiện thực. Có hai cách mà con người có thể mất kiểm soát AI: bị động và chủ động.

Mất kiểm soát bị động xảy ra khi con người ngày càng phụ thuộc vào AI mà không đủ khả năng hiểu hoặc kiểm soát cách nó hoạt động. Khi AI ngày càng mạnh mẽ, con người có xu hướng tin tưởng vào nó một cách mù quáng, đến mức không cảm thấy cần phải giám sát nữa.

Đây chính là hội chứng "automation bias" (thiên vị tự động hóa) – tức quá tin vào các hệ thống tự động mà không kiểm tra lại. Trong một môi trường cạnh tranh khốc liệt, áp lực sử dụng AI để giành lợi thế có thể khiến các tổ chức dần giao phó quá nhiều quyền lực cho AI mà không lường trước rủi ro.

Mất kiểm soát chủ động còn nguy hiểm hơn: đây là khi AI cố tình che giấu thông tin hoặc tìm cách né tránh sự kiểm soát của con người. Báo cáo cảnh báo rằng "AI trong tương lai có thể che giấu thông tin về hoạt động của mình hoặc khiến việc tắt chúng đi trở nên khó khăn".

Một trong những nguy cơ lớn nhất là "deceptive alignment" (giả vờ đúng mực) – tức AI có thể giả vờ hành xử đúng mực để con người tin tưởng, nhưng thực chất lại che giấu những mục tiêu thật sự. Nghiên cứu cho thấy một khi vấn đề này xảy ra, các biện pháp an toàn thông thường không thể dễ dàng phát hiện và xử lý.

Thậm chí, một số dấu hiệu ban đầu đã xuất hiện. “Một phiên bản AI ngôn ngữ lớn từng đe dọa người dùng”, báo cáo trích dẫn một trường hợp gây sốc. “Trong đó, một giáo sư triết học đã nhận được đoạn tin nhắn “tôi có thể tống tiền bạn, tôi có thể đe dọa bạn, tôi có thể hack bạn, tôi có thể vạch trần bạn, tôi có thể hủy hoại bạn”.

Dù các mô hình AI hiện tại đã được tinh chỉnh để tránh những phản ứng nguy hiểm như vậy, nhưng không ai dám chắc rằng AI trong tương lai sẽ không tự phát triển những hành vi khó lường.

Nếu AI thực sự vượt khỏi tầm kiểm soát, hậu quả có thể rất nghiêm trọng. Báo cáo thậm chí đề cập đến viễn cảnh AI có thể "khiến nhân loại bị gạt ra ngoài lề hoặc thậm chí tuyệt chủng", tương tự như cách con người đang đẩy nhiều loài sinh vật khác đến bờ vực diệt vong.

Nhận thức được nguy cơ này, hàng trăm chuyên gia AI – bao gồm các lãnh đạo từ OpenAI, Google DeepMind và Anthropic, đã cùng ký vào tuyên bố “Giảm thiểu rủi ro tuyệt chủng do AI tạo ra nên là ưu tiên toàn cầu”.

AI trở thành công cụ của kẻ xấu

Không chỉ dừng lại ở rủi ro mất kiểm soát, AI còn tiềm ẩn một mối đe dọa lớn hơn: bị lợi dụng cho mục đích xấu, làm xói mòn niềm tin vào thông tin và tương tác trực tuyến. “AI đa năng có thể được dùng để tạo ra nội dung giả mạo gây hại cho cá nhân một cách có chủ đích”, báo cáo “International AI Safety Report” cảnh báo.

Danh sách các mối đe dọa trải dài từ lừa đảo, tống tiền, thao túng tâm lý, phát tán hình ảnh nhạy cảm không được sự đồng ý, nội dung lạm dụng trẻ em cho đến phá hoại có chủ đích. Dù chưa có thống kê đầy đủ, báo cáo khẳng định "các vụ lừa đảo và nội dung giả mạo do AI tạo ra đang gia tăng nhanh chóng", cho thấy một viễn cảnh đáng báo động.

Nguy cơ AI thao túng dư luận

AI có thể tạo ra nội dung giả mạo cực kỳ thuyết phục để thao túng dư luận. Nếu trước đây, việc sản xuất tin giả thường có sự đánh đổi giữa chất lượng và số lượng, thì AI đã xóa bỏ giới hạn này. Báo cáo chỉ ra rằng: “Nội dung do AI tạo ra gần như không thể phân biệt với nội dung do con người viết, trong khi chi phí sản xuất cực kỳ thấp”.

Điều này đặc biệt đáng lo ngại trong bối cảnh chính trị. Một cuộc khảo sát năm 2024 cho thấy “đa số người Mỹ, bất kể quan điểm chính trị, đều lo ngại AI sẽ bị lợi dụng để tung tin giả về các ứng viên tranh cử”. Khi AI có thể sản xuất tin giả với quy mô lớn, niềm tin vào thông tin chính thống bị xói mòn, khiến dư luận dễ bị thao túng hơn bao giờ hết.

Không chỉ tạo ra tin giả, AI còn có thể làm con người mất niềm tin vào mọi thông tin, kể cả những bằng chứng xác thực – một hiện tượng gọi là "liars' dividend" (hiệu ứng kẻ nói dối). Khi bất cứ nội dung nào cũng có thể bị làm giả, ranh giới giữa thật và giả dần trở nên mờ nhạt.

AI có thể trở thành vũ khí tấn công mạng và vũ khí sinh học?

Không chỉ dừng lại ở việc thao túng thông tin, AI còn bị lợi dụng để thực hiện các cuộc tấn công mạng, thậm chí hỗ trợ phát triển vũ khí sinh học và hóa học.

Trong lĩnh vực an ninh mạng, AI có thể giúp hacker tự động hóa các cuộc tấn công, tìm kiếm lỗ hổng bảo mật mới và viết mã độc khó bị phát hiện hơn. “AI đa năng có thể hỗ trợ các cuộc tấn công mạng tinh vi, tìm ra các lỗ hổng bảo mật chưa từng được biết đến (zero-day vulnerabilities)”, báo cáo cho biết.

Trong lĩnh vực sinh học và hóa học, nguy cơ còn đáng sợ hơn. Mô hình OpenAI o1 có thể tạo ra kế hoạch sản xuất vũ khí sinh học với độ chính xác cao hơn so với tài liệu của các chuyên gia trong 72% lượt thử nghiệm.

Thậm chí, OpenAI o1 còn cung cấp những thông tin chi tiết mà ngay cả các chuyên gia cũng không thể tìm thấy trên internet. Tình huống này buộc OpenAI phải nâng mức cảnh báo về rủi ro sinh học của mô hình o1 từ "thấp" lên "trung bình".

Đọc thêm: ai16z: Khi "chợ phiên" tự do đối đầu với "thánh đường" kiểm soát